Io non sono la persona più adatta a spiegarvi quello che realmente ha realizzato l' Intel.

Ma quei pezzi che capisco posso dire che sono rimasto quasi commosso perche' e' una vita che vorrei vedere utilizzato il ray tracing nei giochi (che se ho capito in parte viene già usato se non erro, ma giusto ' A-B-C).

http://www.tgdaily.com/html_tmp/content-view-37925-113.html

La cosa buffa e' che fino a pochi mesi fà si diceva che le CPU erano alla frutta e che presto le GPU sarebbero andate per i fatti loro.

Adesso già si ipotizza la fine delle GPU in un prossimo futuro.

Magari visto che la Nvidia pensa alle CPU e l' ATI ha alzato bandiera bianca era giusta la seconda opzione.

azzarola!

riassunto per chi non ha voglia di leggere il WOT, inglese e in linguaggio nerdico ?

cioè ho capito la cosa, ma a grandi linee..in dettaglio come puo' una cpu sostituire la gpu ?

cioè ho capito la cosa, ma a grandi linee..in dettaglio come puo' una cpu sostituire la gpu ?

spiegate, che cazz'è?

Ray tracing in realtime? finché non lo vedo non ci credo

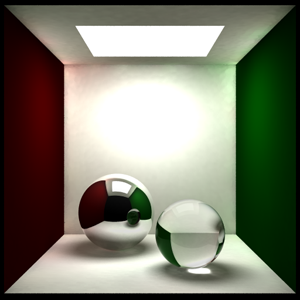

cmq ve la faccio semplice: il ray tracing prende ogni raggio luminoso e lo fa rimbalzare nella "scena" da calcolare. in base a come colpisce gli oggetti, si "colora" e quando finisce ne "l'occhio" della telecamera viene tenuto in considerazione.

questo permette di calcolare tutti gli effetti geometrici della luce, come riflessioni, rifrazioni, diffrazioni (o meglio alpha blending), interriflessioni tra oggetti, ombre castate/portate e così via. è ovviamente molto oneroso in una scena complessa, e quindi è pressoché impossibile farlo girare ad un frame rate sensato.

esempio di raytracing:

gli si è (finora) preferito il ray casting, in cui si scansisce ogni "futuro pixel" della schermata alla ricerca di oggetti (il "cast" va al contrario, dall'occhio alle superfici) e si ragiona su cosa visualizzare a posteriori. molto più performante, ma prono ad artefatti e decisamente basso di qualità. inoltre non permette praticamente alcun effetto realistico, poiché i "raggi" non rimbalzano tra gli oggetti.

cmq ve la faccio semplice: il ray tracing prende ogni raggio luminoso e lo fa rimbalzare nella "scena" da calcolare. in base a come colpisce gli oggetti, si "colora" e quando finisce ne "l'occhio" della telecamera viene tenuto in considerazione.

questo permette di calcolare tutti gli effetti geometrici della luce, come riflessioni, rifrazioni, diffrazioni (o meglio alpha blending), interriflessioni tra oggetti, ombre castate/portate e così via. è ovviamente molto oneroso in una scena complessa, e quindi è pressoché impossibile farlo girare ad un frame rate sensato.

esempio di raytracing:

gli si è (finora) preferito il ray casting, in cui si scansisce ogni "futuro pixel" della schermata alla ricerca di oggetti (il "cast" va al contrario, dall'occhio alle superfici) e si ragiona su cosa visualizzare a posteriori. molto più performante, ma prono ad artefatti e decisamente basso di qualità. inoltre non permette praticamente alcun effetto realistico, poiché i "raggi" non rimbalzano tra gli oggetti.

seee mecojoni

vetro acqua e altre sboronate sarebbero una figata così

vetro acqua e altre sboronate sarebbero una figata così

eh sì

il raytracing è roba da film, non videogioco. se davvero le CPU multicore sono in grado di assicurare 20fps, le GPU sono morte.

il raytracing è roba da film, non videogioco. se davvero le CPU multicore sono in grado di assicurare 20fps, le GPU sono morte.

minchia.

In effetti vorrei vedere questo coso in azione in quanto mi e' difficile credere che giri a 20fps senza trucchi assurdi. Il mio raytracer impiega dai 30 secondi alle 30 ore per frame :P

Il problema con il raytracing puro e' che pure se fosse super veloce, la grafica raster (quella usata in tutti i giochi 3d per ora) e' nettamente piu' realistica di qualsiasi cosa generata dal raytracing. L'unica cosa che riesce a fare infinitamente meglio dei raster sono superfici riflettenti e trasparenti, ma non conosco molti giochi che siano fatti solo di quelle (magari un need for speed o forza motorsport, ma gl fare il terreno in raytracing).

Il problema con il raytracing puro e' che pure se fosse super veloce, la grafica raster (quella usata in tutti i giochi 3d per ora) e' nettamente piu' realistica di qualsiasi cosa generata dal raytracing. L'unica cosa che riesce a fare infinitamente meglio dei raster sono superfici riflettenti e trasparenti, ma non conosco molti giochi che siano fatti solo di quelle (magari un need for speed o forza motorsport, ma gl fare il terreno in raytracing).

Ecco il punto sta qui.

Tra scindere la propaganda dalla realtà.

16 core accuratamente ottimizzati per farlo ,possono magari gestire 3 milioni di traccianti,siccome l' Intel in questi calcoli non e' mai stata seconda a nessuno ci si può anche credere.

Ma gestire il resto della grafica...chi lo fa ?

la gpu

radiosity >> raytracing

cmq nel penultimo shot c'e' scritto in alto 17 fps

E' una menomazione del raytracing.

Secondo me hai ragione.

Per me gli sviluppi piu` immediati saranno sulla global illumination in real time.

A mio avviso se l' Intel ha fatto vedere una cosa del genere ha un suo perche',non e' solo un esercizio di stile.

UN qualche scopo tutti questi core dovranno avere un giorno,per aprire Dreamwaver mi sembrano un pochino sprecati.

già, ma photon mapping >> radiosity

caustiche

subsurface scattering

QW pensavo Quake World...

Oh signore, pregate che non facciano Crysis 2 o 3 con questo sistema, altrimenti ci inondano di cloni di Crysis3ColRayTracingOwnsYOu  .

.

.

.

Ma se già ora crysis gira a 2fps