Ma si figurati, ci smanetto un po’ intanto cosi capisco il linguaggio da usare.

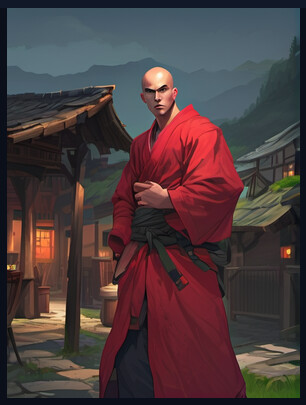

Aggiungendo sto pacco di negative: text, watermark, low-quality, oriental, signature, downsampling, aliasing, distorted, blurry, glossy, blur, jpeg artefacts, compression artefacts, poorly drawn, low-resolution, bad, distortion, twisted, excessive, exaggerated pose, exaggerated limbs, grainy, symmetrical, duplicate, error, pattern, beginner, pixelated, fake, hyper, glitch, overexposed, high-contrast, bad-contrast, blurry eyes piu’ il lora <lora:Concept Art Eclipse Style LoRA_Pony XL v6:1> anche se non c’entra un cazzo con SSD-1B, esce roba ancora piu’ precisa per dire

Non mi interessa roba iper realistica. Anzi se e’ drawing e’ decisamente meglio

voglio capire come editare solo parti dell’immagine tra l’altro, tipo vorrei schiaffargli un tattoo sulla fronte, pensavo fosse in qualche opzione dell’img2img ma non capisco quale