{

"prompt": "(2d artwork, drawing), young male, fantasy character, monk warrior , bald, black eyes, shaolin clothes, looking at viewer, hood, red tunic , collared shirt, cowboy shot, fantasy city streets",

"seed": 94761692,

"used_random_seed": true,

"negative_prompt": "realistic, photograph,",

"num_outputs": 1,

"num_inference_steps": 25,

"guidance_scale": 7,

"width": 512,

"height": 1024,

"vram_usage_level": "high",

"sampler_name": "dpmpp_sde",

"use_stable_diffusion_model": "dreamshaper_8",

"clip_skip": true,

"use_vae_model": "",

"stream_progress_updates": true,

"stream_image_progress": false,

"show_only_filtered_image": false,

"block_nsfw": false,

"output_format": "png",

"output_quality": 95,

"output_lossless": false,

"metadata_output_format": "none",

"original_prompt": "(2d artwork, drawing), young male, fantasy character, monk warrior , bald, black eyes, shaolin clothes, looking at viewer, hood, red tunic , collared shirt, cowboy shot, fantasy city streets",

"active_tags": [],

"inactive_tags": [],

"use_lora_model": "more_details",

"lora_alpha": "0.5",

"enable_vae_tiling": true

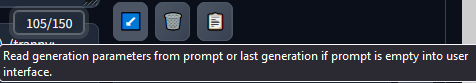

}edit:

questo invece è come era impostato ED