Nexus one è uscito 3 anni dopo il primo iPhone e comunque pur essendo una gran novità lato Android col cavolo che lo schermo restituiva la stessa sensazione di reattività

E infatti io che ho scritto?

Che hanno dovuto cancellare e ripartire da zero dopo che è uscito iPhone.

Questo per mettere a tacere tutte le cazzate del “nessuno ha considerato iPhone all’inizio” che è appunto una cazzata.

Scusate, primo iphone 2007.

Htc dream 2008. Ed aveva lo schermo capacitivo.

Io presi l’htc dream nel 2009 o 2010 (usato), marchiato vodafone.

Che differenza c’è tra lo spatial video e un video 3d?

Possono indicare la stessa cosa, dipende cosa intendi tu per video 3d e in quale formato.

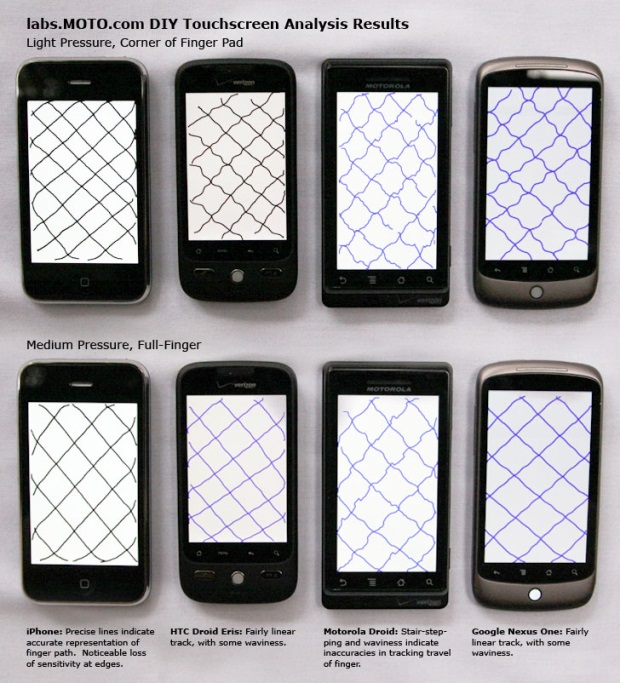

Mi son espresso male: nexus one è uscito tre anni dopo il primo iPhone e pur essendo stato un buon (notevole) balzo in avanti per quanto concerne il touch col cavolo che aveva pareggiato la controparte melata

doubt

Per riprendere il punto su architetti e vr, a malapena viene usato il BIM, nel senso che nella media (ma dovrei dire nella quasi totalità) di ingegneri e architetti le tavole sono fatte con autocad e in 2d.

Proprio oggi dopo aver ritracciato le varie tavole di un progetto portandolo da 2d a 3d, proprio da autocad a un bim (che non vuol dire importare il dwg nel programma ma ritracciare tutto), ho voluto provare l’ interconnessione tra archicad e twinmotion, con l’ esplorazione della scena in 3d.

Fico, molto (e non con apple ma con un umile quest 2), ma resta un qualcosa che resta nell’ ambito presentazione, sarebbe troppo rischioso editare direttamente dal VR e rischiare di rompere il progetto.

Le implicazioni sono molte, potrebbe essere utile per un’agenzia immobiliare, per uno studio di architettura, anche per i geometri ed i manovali sul campo volendo, ma serve che tutta questa gente cambi il modo di lavorare e sinceramente non lo vedo dietro l’ angolo.

Ripeto, parlate con un architetto e chiedetegli se sa cosa è il BIM. Ve ne osannerà tutte le qualità che ha nella progettazione E nell’ esecuzione.

Poi chiedetegli “quindi progetti in BIM” e la risposta è “no”

Ripeto. Dimmela tu la differenza, che lo sai. Nell’ esperienza dell’ utente, non nel “con cosa si registra, quanti pixel, che bitrate usa, che compressione ha”.

Io non lo so, per questo chiedevo a te che ne osanni le qualità e dici che è qualcosa di mai visto.

È letteralmente passata una vita e mi sembra fosse più dovuto a qualcosa lato software che hardware però il risultato finale, la cosa che davvero conta, è che in quel campo l’iPhone era ancora senza eguali.

(Pur avendo una memoria davvero di merda lo ricordo perché ben prima che uscisse la ricerca di moto, spunto dal quale poi TechCrunch come altre testate ci fecero qualche articolo, l’eventuale chiusura del gap di feeling dello schermo tra iPhone e concorrenza fu uno dei punti salienti di una mia analisi di mercato)

Non vivo in US non l’ho provato quindi non posso dirti cosa ho provato personalmente.

Ci si può basare su due cose solamente: su cosa è tecnicamente e su quello che riporta chi l ha provato.

La giornalista se non erro di the verge o wsj una delle prime recensioni ha detto che ha provato un emozione nel rivedere dei filmati della figlia. Ho sentito pareri abbastanza allineati a questo.

Detto questo le emozioni sono sempre personali e soggettive magari a me o te non suscita alcuna emozione.

Da un punto di vista tecnico è un video stereoscopico, registrato con due camere separate, formato e codec definiti, con spatial audio, e metadati per i sub etc

Qui spiega un po https://developer.apple.com/av-foundation/Stereo-Video-ISOBMFF-Extensions.pdf

Un film che guardi da Netflix o altri streaming non è stereoscopico quindi tornando al contesto iniziale da dove è iniziato il tutto non puoi comparare spatial video a guardarsi un film in VR, non sono la stessa cosa, se invece hai un film che è stato registrato in formato stereoscopico allora probabilmente l esperienza è molto simile o identica se rispetta gli stessi parametri.

Supporto sperimentale nella prossima versione di Unreal Engine.

Sembrano buone notizie incoraggianti sul fatto che c’è interesse, anche da parte di Epic che se potesse detonare Apple con un bottone lo farebbe all’ istante ![]()

sicuramente un bene il supporto degli engine, la cosa meno buona è che supportano solo la parte vr.

quindi niente di nuovo?

Dipende dal servizio di streaming, la cosa positiva è che magari aprono allo streaming in 3d rimettendo film originariamente girati in 3d (che ci sono, ci sono stati un paio di anni dove il 3d era il punto di forza di bluray e tv con occhialini attivi).

Prime ha lanciato da poco l’app primevr su oculus, con qualche film o documentario in 3d o con video 360°. Li divido perchè appunto ci sono sia video “stereoscopici” che video a 360°

Poi, di servizi di streaming spaziali, che danno emozioni e che fanno sembrare di essere protagonisti del film me ne vengono in mente più di uno, ma da quanto ho capito sono preclusi a chi ha il visore apple ![]()

ah, ultima cosa che mi sono scordato di dire: non so se hai mai provato un visore per più tempo e su scene ad alto tasso di adrenalina.

Io ho provato f1 2023. Con il volante. ecco, dopo pochi minuti ho dovuto staccare. Immaginati un film con una scena di inseguimenti, o semplicemente un qualsiasi movimento della camera.

in quel momento speri di non avere più la visione stereoscopica, in modo che il tuo cervello capisca che stai guardando un film e non sei tu a muoverti.

non so potrebbe essere niente di nuovo da un certo senso se la vedi come “esistevano gia’ in quel formato” pero’ se pensi che anche il primo iPhone non ha inventato il touchscreen magari una chiave di lettura sta nel fatto che puo’ rendere *democratico questo formato grazie al fatto che gli ultimi iPhone possono registrare spatial video / video stereoscopici / video 3d come preferite chiamarli e quindi tutto ad un tratto hai in tasca un device che puo fare queste registrazioni e un visore per riprodurle (o usane un altro più economico).

- ho messo volutamente asterisco visto il costo dei device, ma penso si capisca il senso

Un po’ di nuovo in realtà, non c’entra nulla col classico metodo di registrare 3d, se non altro per come lo vuole codificare Apple.

Al momento il formato massimo di encoding è

La differenza col binario classico è che prevedono un encoding dove domina l’occhio sinistro e viene salvato un delta per il destro. In sintesi in fase di encoding ottieni una vera e propria depth map (quindi stile star wars lo potresti vedere anche di lato, per dire) che puoi girare quindi non solo coi setup classici ma anche con lenti molto vicine o con un sensore time-of-flight, al contrario del classico file doppio pov dove devi avere la doppia camera a distanza interpupillare.

Questo se ho compreso bene le istruzioni e la documentazione.

Lato videomaker visto che penso sia quello che ti interessa, presumo che inizialmente si potrà fare solo su iPhone 16 a salire (usciranno appunti i modelli con le lenti posizionate correttamente per girarli “nativamente”).

Apple ha fatto un regalo ai dipendenti che hanno lavorato sul vision

![]()

“Thank you for helping the world say hello to Apple Vision Pro.”

![]()

Ipotizzo che siano già belli che pagati eh ![]()

Ecco qua la cosa si fa più interessante. A giudicare dal formato viene fatto un encoding dove hai l’occhio dominante con il 100% del frame (come oggi) e il secondario “interpolato” -che sia con con una mappa o per differenza cambia il giusto.

Ad occhio migliora lato bitrate delegando alla CPU il decoding. Potrebbe anche essere utile per sgravare il compito della GPU in ambito gaming (forse) renderizzando solo metà del frame + aggiungendo le informazioni mancanti (questo però forse è già più gravoso)